2 月 1 日,一名 2 岁婴儿同时登上了 Science 和 Nature 的首页。

Science 截图(左)和 Nature 截图(右)

在这项来自纽约大学数据科学中心的研究中,研究人员在一位名叫 Sam 的男婴头上佩戴一个安装有摄像头的头盔,从 Sam 个月大到两岁左右,他每周两次佩戴相机,每次每次一小时左右(大约是他清醒时间的 1%)。研究共进行了 61 小时婴儿视角的记录。

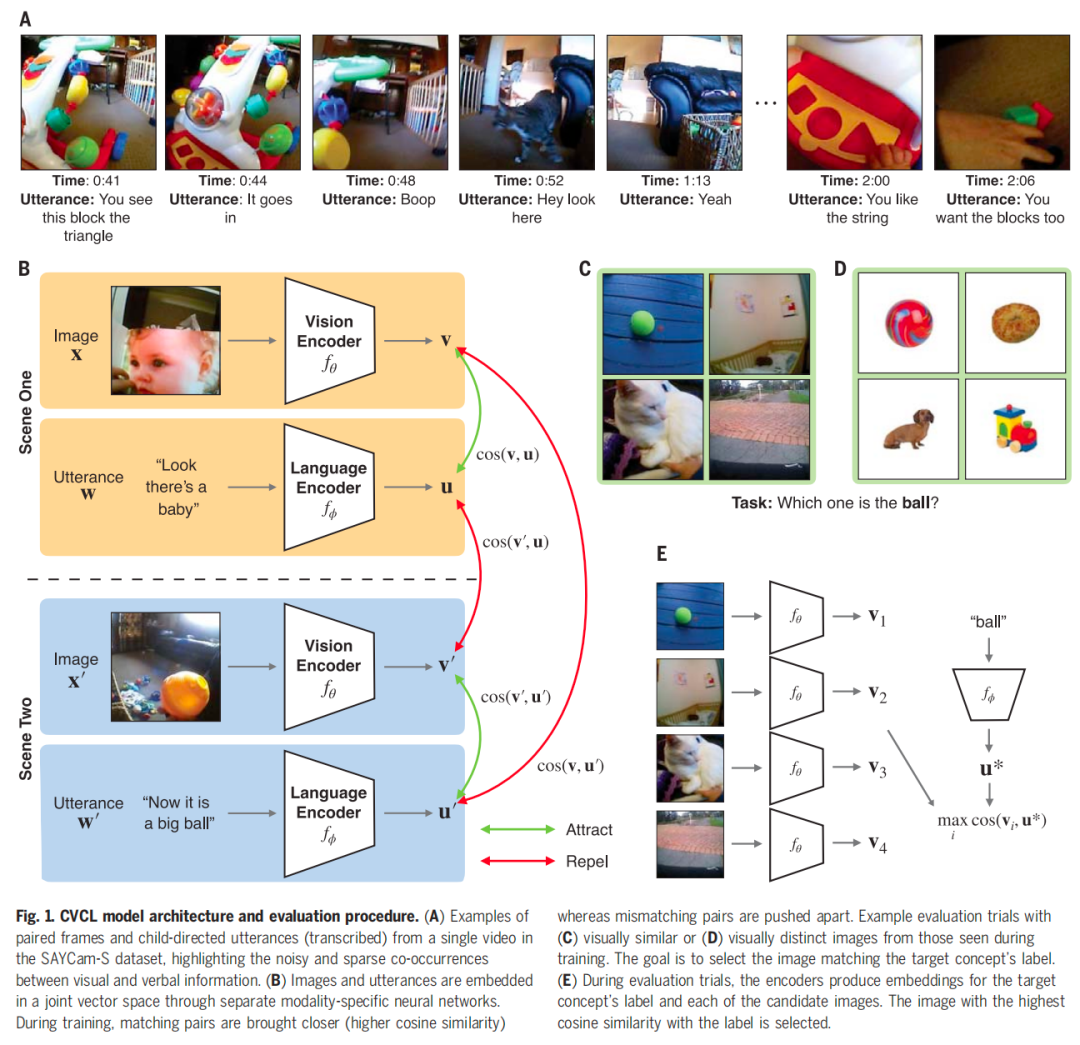

随后,研究人员根据记录的信息,来训练他们研发的一种 AI 模型。该模型接触了从玩耍、阅读和吃饭等活动中捕获的 250,000 个单词和相应的图像,使用了一种称为对比学习的技术,来了解哪些图像和文本倾向于结合在一起,哪些不结合在一起,从而建立可用于预测某些单词所指的图像的信息,例如「球」和「碗」。

为了测试 AI 学习结果,研究人员要求 AI 模型将一个单词与四个候选图像之一进行匹配,这项测试也用于评估儿童的语言能力。它在 62% 的时间里成功地对对象进行了分类——比偶然预期的 25% 好得多,并且与使用来自该数据集之外的 4 亿个图像文本对进行训练的类似 AI 模型相当。

论文截图

对于某些单词,例如「苹果」和「狗」,该模型能够正确识别以前未见过的例子,成功率平均在 35%。

该研究的合著者、纽约大学人工智能研究员 Wai Keen Vong 表示,结果表明人工智能可以帮助我们了解人类如何学习。Vong 表示,这一点此前尚不清楚,因为 ChatGPT 等其他语言学习模型是在数十亿个数据点上学习的,这与婴儿的现实世界体验无法相比。

作者希望,这项研究能够引发关于儿童如何学习语言的长期争论。人工智能只能通过在它看到的图像和文字之间建立关联来学习;它没有使用任何其他有关语言的先验知识进行编程。Vong 说,这对一些认知科学理论提出了挑战,这些理论认为,为了给单词赋予意义,婴儿需要一些关于语言如何运作的先天知识。

加州大学默塞德分校的认知科学家 Heather Bortfeld 表示,这项研究是理解儿童早期语言习得的「一种令人着迷的方法」。(策划:z_popeye|监制:gyouza、carollero)

發表評論 取消回复