IT之傢今日(5月13日)消息,研究人員Sepp Hochreiter和Jürgen Schmidhuber在1997年共同提出瞭長短期記憶(Long short-term memory,LSTM)神經網絡結構,可用來解決循環神經網絡(RNN)長期記憶能力不足的問題。

而最近Sepp Hochreiter在arXiv上發佈論文,提出瞭一種名為 xLSTM(Extended LSTM)的新架構,號稱可以解決LSTM長期以來“隻能按照時序處理信息”的“最大痛點”,從而“迎戰”目前廣受歡迎的Transformer架構。

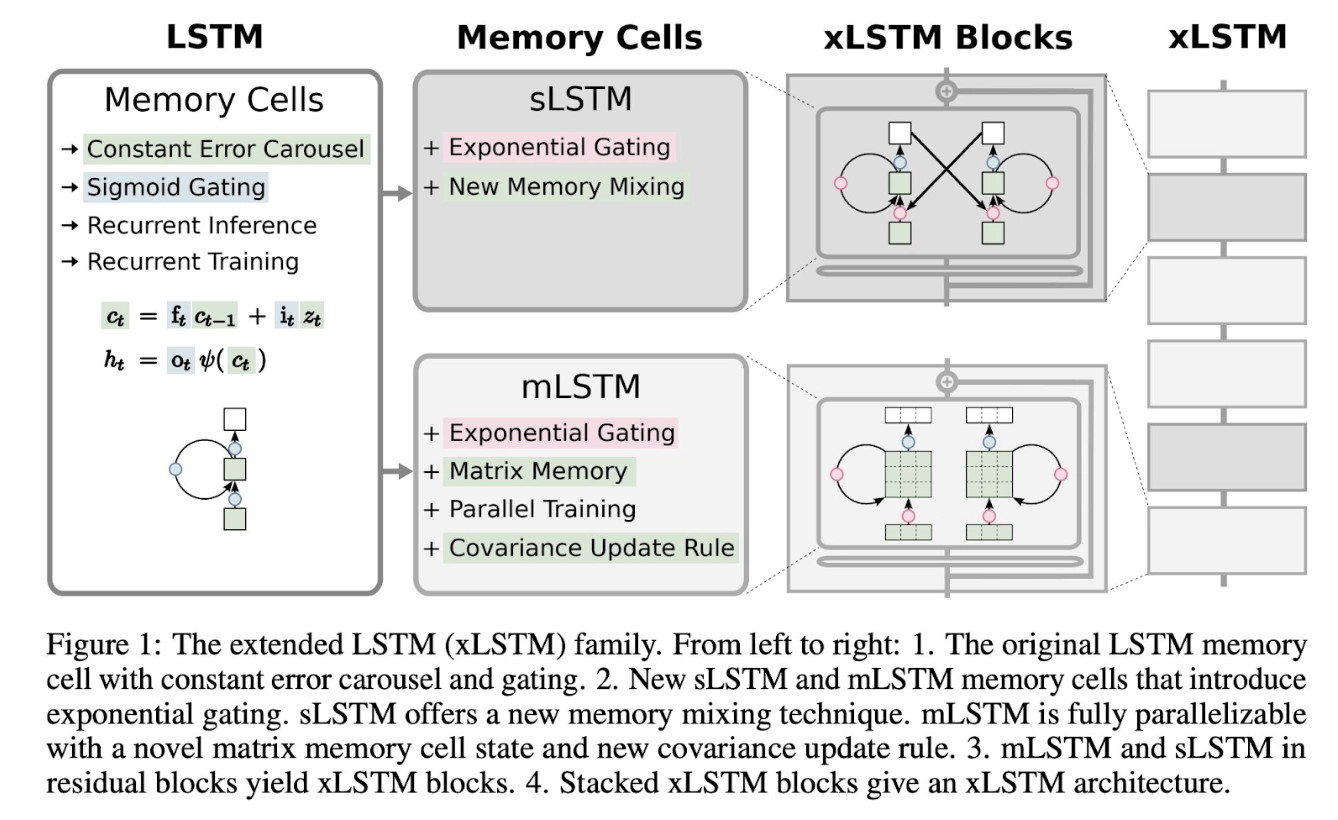

據悉,Sepp Hochreiter在新的xLSTM架構中采用瞭指數型門控循環網絡,同時為神經網絡結構引入瞭“sLSTM”和“mLSTM”兩項記憶規則,從而允許相關神經網絡結構能夠有效地利用RAM,實現類Transformer“可同時對所有Token進行處理”的並行化操作。

團隊使用瞭150億個Token訓練基於xLSTM及Transformer架構的兩款模型進行測試,在評估後發現xLSTM表現最好,尤其在“語言能力”方面最為突出,據此研究人員認為xLSTM未來有望能夠與Transformer進行“一戰”。

發表評論 取消回复