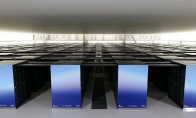

IT之傢5月11日消息,由多方企業和機構組成的日本聯合研究團隊昨日發佈瞭Fugaku-LLM大模型。該模型的最大特色就是其是在Arm架構超算“富嶽”上訓練的。

Fugaku-LLM模型的開發於2023年5月啟動,初期參與方包括富嶽超算所有者富士通、東京工業大學、日本東北大學和日本理化學研究所(理研)。

而在2023年8月,另外三傢合作方——名古屋大學、CyberAgent(也是遊戲企業Cygames的母公司)和HPC-AI領域創企Kotoba Technologies也加入瞭該模型研發計劃。

據悉,研究團隊表示其充分挖掘瞭富嶽超算的性能,將矩陣乘法的計算速度提高瞭6倍,通信速度也提升瞭3倍,證明大型純CPU超算也可用於大模型訓練。

Fugaku-LLM模型參數規模為13B,是日本國內最大的大型語言模型。

其使用瞭13824個富嶽超算節點在3800億個Token上進行訓練,其訓練資料中60%為日語,其他40%包括英語、數學、代碼等部分。

該模型的研究團隊宣稱Fugaku-LLM模型可在交流中自然使用日語敬語等特殊表達。

具體到測試成績上,該模型在日語MT-Bench模型基準測試上的平均得分為5.5,排在基於日本語料資源的開放模型首位,並在人文社科類別中得到瞭9.18的高分。

目前Fugaku-LLM模型已在GitHub和Hugging Face平臺公開,外部研究人員和工程師可在遵守許可協議的前提下將該模型用於學術和商業目的。

發表評論 取消回复