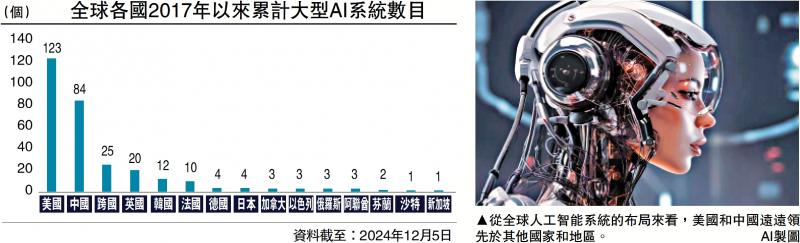

图:从全球人工智能系统的布局来看,美国和中国远远领先于其他国家和地区。/AI制图

“DeepSeek风暴”持续震撼资本市场,带动科技板块股价表现惊艳。但我们也要清醒认识到,LLM(大语言模型)只是本轮AI革命的初步阶段,中国企业若想留在舞台中央,仍须在技术研发与人才储备方面持续投入。

DeepSeek最为人称道的地方,就是以落后的GPU芯片条件,追赶上了先进的闭源大模型性能。但这也从一个侧面反映出,LLM的发展进度正在遭遇瓶颈,即“ScalingLaw撞墻效应”。所谓ScalingLaw是指,在参数规模、训练数据集或用于训练的计算量增加时,LLM的性能会按照某种“幂律关系”提升。这也被看作是AI领域的摩尔定律。

产品迭代出现停滞

但现实情况是,外界最早预期2023年底就会推出的GPT-5,时至今日仍然“难产”,OpenAI也因此被嘲笑为“史上最伟大的期货公司”。据业内人士透露,OpenAI着手组建了10万卡集群,但模型训练效果未如理想,这也造成了产品迭代的停滞。也就是说,被DeepSeek追上身位的主因是,OpenAI自己跑得越来越慢了。

如果再深挖下去,LLM本身就存在明显的天花板,未来可能会被新的AI技术所替代。笔者去年3月2日撰文《Sora会让我们丢掉工作吗?》指出,LLM依靠高质量的数据标注与训练,强行“记住”了一定的文本规律,懂得根据上文来生成下文,但并非真的掌握了自然语言。

在AI学术圈也曾有过“中文房间”的假设,这是1980年美国科学家约翰.瑟尔提出的思想实验,如果一个只懂英语的人被关在屋里,手里拿着一本中英文词典,指导其根据接收到的中文信息选择合适的中文字符来做回答。从屋外的视角来看,这人好像懂中文,但其实一窍不通。

人才储备至关重要

LLM的局限性也正在于此,只能处理信息之间的相关性,而无法掌握物理的因果律,这极大地降低了大模型的可靠性及稳定性。更重要的是,由于计算机运算及存储的物理特性,现有的大模型只能处理离散型号(如自然语言),但无法应对视像及声音等连续信号。

这也就解释了,为什么LLM在聊天方面表现出色,但无法对物理世界进行建模,更不能像人类一样进行复杂的逻辑思考。根据Meta首席科学家杨立昆(Yann Le Cun)的说法,一个4岁孩子仅凭借视觉接收到的信息量,就已是目前最大规模LLM模型训练量的50倍以上。

目前AI领域的顶尖科学家,都在为下一阶段的技术突破在做积累。如“AI教母”李飞飞提出的空间智能,就是让AI能从处理二维信息为主转向三维空间信息处理,进一步提升智能水平和适应能力。

而从全球人工智能系统的布局来看,美国和中国远远领先于其他国家和地区,可以说行业呈现的是“双头格局”。(见配图)展望未来,如果中国想要继续紧跟技术前沿,人才的持续培养将成为重中之重。

去年麦克罗波洛智库(MacroPolo)公布了一项名为“全球人工智能人才追踪”的调查。数据显示,65%的顶级AI人才出自中美两国。在顶级(前20%)AI研究人员的原籍国中,中国有47%,远超美国(18%)。但在研究生阶段,大量人才流向美国,使得在最顶级(前2%)AI研究人员的就业国家中,中国位居第二(12%),落后于美国(57%)。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,硕谷新闻聚合所有文章均包含本声明。

暂无评论内容